上一篇我們看了如何使用Ollama快速方便的去跑model,今天我們要來看另一種部屬模型的方式,也就是用HuggingFace的Transformer!

首先我們就先來了解一下HuggingFace和transformer是什麼

HuggingFace是一個集合AI資源,AI開發的重要平台,平台上有幾乎所有現在熱門的最新模型,像是llama、gemma、mistral等等都有,除了這些,HuggingFace還是一個開放的AI Community,所有人,不管是企業、機構、還是個人開發者,都可以在上面上傳分享自己的pretrained模型,也就是說HuggningFace就是一個非常巨大而且完整的model library,大家都可以輕鬆的下載、部屬並使用這些模型,讓AI的開發流程更為便捷簡易,就像它們官網上的標語

"The AI Community building the future. The Home of Machine Learning."

transformer是HuggningFace的核心架構,這個架構有API可以直接來使用平台上這些模型,像是Bert、GPT、llama等等,並在這些基礎上去開發,例如進行微調或是其他運用,他也可以將模型直接保存在本地,再由這個架構去調用,這也是我們此篇會做的事!

那我們就開始進行transformer運行模型的實作吧!

首先先在環境裡下載transformer和huggingface-hub套件

transformer自然就是核心框架,huggingface-hub則是要讓某些需要授權的模型可以使用

這邊可以選擇使用conda,或是直接用pip( python 套件管理工具) 進行安裝,只需要確認你目前activate的環境是我們所使用的虛擬環境,不會影響到全局的部分就可以了。

指令如下

pip install transformers huggingface_hub

// 通道直接使用conda-forge就可以了

conda install conda-forge::transformers

conda install conda-forge::huggingface_hub

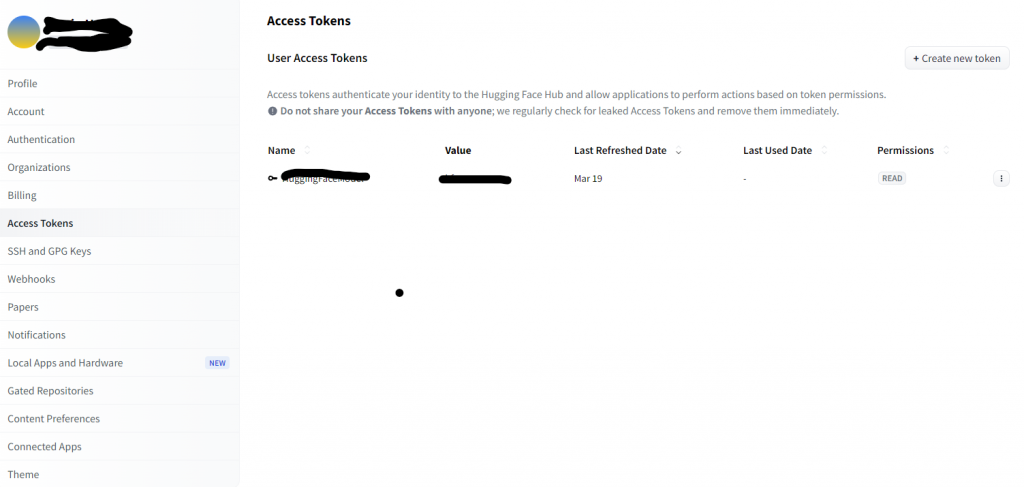

接下來我們先去HuggingFace官網註冊帳號,並申請token

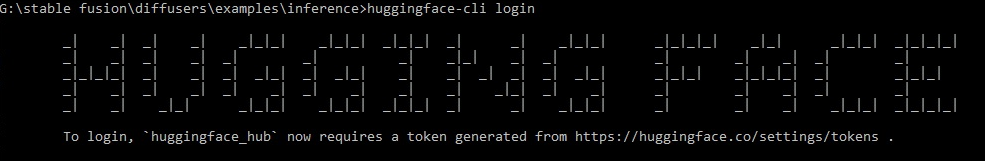

申請完之後,在專案的terminal中輸入以下指令

huggingface-cli login

一切都ok的話就會出現這樣

我們就可以將剛剛申請的token輸入進來了!要這樣是因為有些模型需要你先在HuggingFace的模型頁面上進行申請的動作,直到他申請通過才會有使用權限。

這邊特別需要注意一下,這邊輸入的token都會是隱形的,也就是就算你有複製成功過來,也一樣看不到

且在terminal裡進行複製的動作時,我記得有些複製訊息的方法是不能用的,所以這邊假如失敗的話可以多試幾次。

這樣本地的HuggingFace就設定完了!我們下一篇就馬上來看使用transformer實作運行模型input output的部分!